Als Doktorand ist man nicht frei von Interessenskonflikten -- ganz im Gegenteil. Es ist der Regelfall, dass Experimente nicht funktionieren, oder die gewünschten Ergebnisse ausbleiben, obwohl man technisch einwandfrei gearbeitet hat. Es ist ja das Wesen der Wissenschaft, dass man nie genau weiß, was dabei herauskommt.

An den Früchten der eigenen Arbeit wird man später gemessen, und das ist auch gut so. Um die Karriere zu beschleunigen, kann es dabei sehr attraktiv sein, auf unlautere Mittel zurück zu greifen. Das kann bewusstes Schönrechnen oder Ideenklau sein, oder ganz unbewusst passieren, weil man ein bestimmtes Ergebnis erwartet und eben keine neutrale BeobachterIn ist. So ist beispielsweise das „Ignorieren von allein gefühlsmäßig falschen Daten" offenkundig ein recht verbreitetes Phänomen. Wer hat nicht schon mal den Drang verspürt „Ausreißer" einfach so aus der Datenreihe zu werfen?

Retractions & Fälschungen

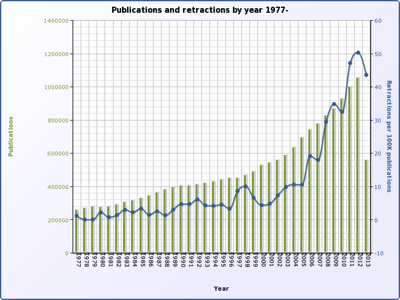

Aber es kommt nicht von ungefähr, dass in letzter Zeit die Rate der offiziell zurückgezogenen Veröffentlichungen so enorm in die Höhe geschnellt ist. Laut Nature wurden im vergangenen Jahrzehnt zehnmal so viele Arbeiten aufgrund von Fehlverhalten zurückgezogen, als noch in den neunziger Jahren. Im gleichen Zeitraum wuchs der wissenschaftliche Output nur um die Hälfte.

In grün: Zeitverlauf des globalen Publikationsvolumens, in blau: die Zahl der zurückgezogenen Artikel, normiert auf je 100.000 publizierte Artikel. Die Rate der Retractions wächst schneller als die Publikationen selbst, das heißt der Prozentsatz der fehlerhaften Artikel am Gesamtkorpus wächst. 2013 ist noch nicht komplett, deshalb fällt es etwas aus der Reihe. (Grafik von pmretract.heroku.com, bezieht sich auf Daten aus der biomedizinischen Datenbank PubMed)

Schwer vorstellbar, dass man das lediglich durch die Effizienz des Internets bei der Fehlersuche wegerklären kann. Der Zeitverlauf zeigt die deutlichste Zunahme ab Mitte der Nullerjahre -- wo elektronische Publikationen und Internet-basierte Literaturrecherche in den Naturwissenschaft schon längst Standard waren. Könnten nicht noch andere strukturelle Veränderungen in der Wissenschaft dafür verantwortlich sein?

Die Gründe

Zu den Motivatoren für Fehlverhalten unter DoktorandInnen und Postdocs zählt sicher der relativ hohe Leidensdruck, den man für eine erfolgreiche wissenschaftliche Karriere in Kauf nehmen muss: unsichere Perspektiven, generelle Familienunfreundlichkeit, prekäre Beschäftigungsverhältnisse, Unterbezahlung und das ständige Umziehen von Land zu Land -- das alles über viele Jahre hinweg. Die meisten werden den Lohn für diese Entbehrungen nicht auf's Spiel setzen, aber es soll ja Menschen geben, die nicht so hart im Nehmen sind. Wer weiß, ob dann nicht ein entscheidender Durchbruch kurzzeitige Erleichterung verschaffen kann? Natürlich ist die bewusste Entscheidung, Daten zu fälschen, einfach dumm. Wissenschaft ist langfristig selbstkorrigierend, und früher oder später kommt alles ans Licht (sofern sich jemand dafür interessiert).

Diese Situation hat sich durch eine immens gesteigerte Konkurrenz weiter verschärft. Schwellenländer wie China, Indien und Brasilien haben ihre Forschungssektoren ausgebaut und global gesehen hat sich der wissenschaftliche Output massiv gesteigert -- wie man auch an der obigen Grafik ablesen kann. Davon unabhängig gibt es eine regelrechte Doktorandenschwemme. Immer mehr Leute promovieren. Als wenn das nicht alles schon schlimm genug wäre, werden in den Zeiten der Finanzkrise auch Forschungsbudgets immer knapper, und damit auch die verfügbaren Stellen.

Wie stark sich diese Prozesse im Detail auswirken, kann ich nicht sagen, aber die Konkurrenz um Fördergelder und Stellen ist über die letzten Jahre fraglos stärker geworden, ebenso wie um die Plätze in den begehrten Zeitschriften, die als „Türöffner" für die eigene Karriere dienen. Und da liegt ein nicht zu kleiner Hase im Pfeffer.

„I want good data, a paper in CELL, but I got a project straight from Hell" -- sangen die Alzheimer-ForscherInnen des Zheng Labs vor mehr als zwei Jahren. (Youtube)

Bestimmte Publikationen dienen als Türöffner

Wenn es nämlich darum geht, andere ForscherInnen einzustellen, Förderanträge zu bewerten oder wissenschaftliche Leistungsfähigkeit einzuschätzen, stützen sich viele auf den Journal-Impact-Factor. Diese ungelenk als „Zeitschriften-Durchschlagskraft-Faktor" übersetzbare Zahl spiegelt eine gewisse Hierarchie unter den Zeitschriften wieder -- Cell, Nature und Science mit ihren hohen zweistelligen Faktoren gehören zu den begehrtesten Zeitschriften, in denen auch die ProtagonistInnen des obigen Videos gerne Ergebnisse unterbringen wollen. Tausende andere Journals mit einstelligen JIFs sind weit weniger begehrt. Die Bewertungslogik anhand des JIF folgt einem „je höher die Durchschlagskraft der Zeitschrift, in der die Publikation erschien, desto besser die Publikation, die ForscherIn und damit auch deren Arbeit". Und je besser das Journal ist, in dem man publiziert, desto besser ist die ForscherIn -- logisch, oder?

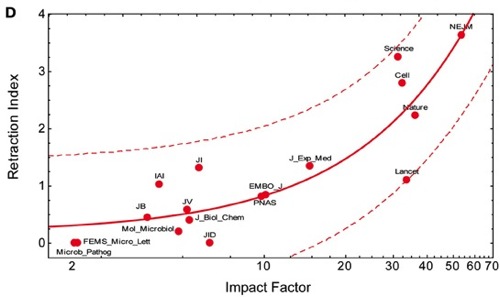

Der Haken ist jedoch, dass die Journal-Hierarchie eher kollektiv „gefühlt" wird und für die Bewertung von Einzelarbeiten und Personen nicht taugt. Der JIF war seit seiner Erfindung in den siebziger Jahren lediglich ein grobes Werkzeug der Bibliotheken, und wurde nie für die Bewertung von Einzelpublikationen oder sogar Personen konzipiert. Wie Prof. Björn Brembs hier detalliert erklärt, kann der JIF nicht die Zahl der Zitierungen für ein bestimmtes Paper vorhersagen, er ist kein gutes Maß für die „Wichtigkeit" oder den „Neuigkeitswert". Die Qualität der Daten ist in Zeitschriften mit hohem JIF nicht besser, als anderswo. Nach allem, was man heute weiß, korreliert der JIF nur mit der Rate der Retraktionen nennenswert, und zwar ganz hervorragend.

Der Impact Factor sagt vor allem eines voraus: Wie hoch die Rate der zurückgezogenen Artikel ist, in denen sie erschienen sind. (Grafik aus diesem Paper)

Das ist eigentlich nicht überraschend, denn die begehrten Journals publizieren in erster Linie das, was die EditorInnen als besonders spektakulär und revolutionär ansehen. Leider haben spektakuläre und revolutionäre Ergebnisse die Angewohnheit, öfters falsch-positiv zu sein. Das heißt, man hat durch Zufall einen Effekt dokumentiert, der bei genauerem Hinsehen verschwindet. Weil er ein Artefakt ist, oder eine statistische Anomalie. Nicht ohne Grund lehnte einer meiner Ex-Chefs das Publizieren und Lesen von Nature und Science kategorisch ab und verglich sie mit der Bild-Zeitung.

Dazu kommt natürlich, dass niemand genau weiß, wie der JIF überhaupt errechnet wird. Das Prinzip ist natürlich bekannt -- die Zahl der Zitierungen, geteilt durch die Zahl der zitierbaren Artikel über einen Zeitraum von zwei Jahren -- aber die Privatfirma Thomson Reuters rechnet ihn völlig intransparent basierend auf einer unklaren Datenbasis aus, und man kann sogar über die Höhe des JIF verhandeln. Was nämlich einen „zitierbarer Artikel" darstellt, ist alles andere, als vorbestimmt.

Wenn man das als Außernstehender liest, wird man vermutlich angesichts der Defizite und der gleichzeitigen Popularität des JIF die Hände über dem Kopf zusammenschlagen. Die meisten dieser Probleme sind vermutlich in den Wissenschaftlerkreisen hinreichend lange bekannt. Das hält aber WissenschafterInnen nicht davon ab, ihn genauso dafür zu benutzen -- und das auch ganz offen zuzugeben. So wäre eben das System, und wie könnte man schon etwas daran ändern? Diese Praxis ist immens weit verbreitet, bis in die höheren Ränge des Wissenschaftsbetriebs.

Fakt ist: die Zahl der High-Impact-Papers auf dem Lebenslauf einer WissenschaftlerIn spiegelt vor allem deren sozialen Status wider. Eine oder mehrere spektakuläre Nature-Publikationen ist für die Bewerbung um Stellen oder Gelder oft ausschlaggebend, und zwar auf allen Hierarchieebenen.

Fazit

Das zunehmende Fehlverhalten ist natürlich kein ausschließliches Phänomen unter jungen WissenschaftlerInnen, und auch der zunehmende Missbrauch des Journal Impact Factor ist wahrscheinlich keine ausschließliche Erklärung dafür. Allerdings stehen junge ForscherInnen unter zunehmendem Druck, möglichst positives und spektakuläres Material zu produzieren. Die Zeiten haben sich geändert, man bekommt heute nicht mehr so schnell ein Paper in Cell unter, wie vielleicht Anfang der neunziger Jahre. Das taugt immerhin als Teilerklärung für die „unzulässigen Abkürzungen".

Ein Weg, wie man dieser Entwicklung entgegentreten kann, ist Chefs und Vorgesetzte auf das Thema anzusprechen, und anzuregen, die San Francisco DORA Declaration on Research Assessment zu unterzeichnen, die sich genau gegen diese Bewertungs-Praxis ausspricht. Denn auch wenn wir das System nicht von heute auf morgen revolutionieren werden, ist es wichtig, gerade die entscheidenden Leute, die von JIF-Publikationen profitieren, über dessen Defizite in Kenntnis zu setzen. Auf zu viel positives Feedback sollte man sich allerdings nicht einstellen.

Hinweis (hinzugefügt am 25.06.): An einer Genderdebatte habe ich kein Interesse, aber ich finde es nicht schlimm, wenn man die unterrepräsentierten weiblichen Forscher explizit mit in die Betrachtung einbezieht.